本文章內容係以參考技術文件為基礎,經由人工智慧(AI)技術進行改寫及重整,旨在提供讀者更清晰易懂之內容呈現。如有任何技術細節上的疑義或需進一步確認,建議讀者參考原始技術文件或與相關技術人員聯繫。

嘿!各位對AI充滿好奇的朋友們,以及我們最給力的AE和銷售夥伴們!

想像一下,如果強大的AI語言模型不再只存在於遙遠的雲端,而是能直接在我們身邊的裝置上運作,那會是多麼令人興奮的事?這不僅意味著更快的反應速度、更高的資料安全性,還能開啟無數創新的應用可能。這正是邊緣AI的魅力所在,而大型語言模型(LLM)的出現,更是將AI的能力推向了新的高峰。

不過,大家可能知道,完整的LLM模型通常非常龐大,需要強大的運算資源。這時候,「小型語言模型」(sLLM)就應運而生了!sLLM是經過優化、體積更小的語言模型,專為在資源有限的邊緣裝置上運行而設計。它們保留了許多LLM的核心能力,同時大幅降低了對硬體的要求。

在研華,我們始終走在技術前沿,不斷探索如何將最新的AI技術落地到我們的硬體平台上。最近,我們的工程師團隊就進行了一項有趣的實驗:在研華基於NVIDIA Jetson Orin平台的邊緣AI系統上,運行DeepSeek R1等sLLM模型! 這項實驗的目標,就是要驗證我們的平台是否能順暢、有效地執行這些先進的sLLM,為未來的邊緣AI應用打下堅實基礎。

接下來,就讓我們一起深入了解這場實驗的精彩過程吧!

實驗主角:研華的Jetson Orin平台 #

這次實驗的主角是研華旗下的兩款基於NVIDIA Jetson Orin的強大邊緣AI平台:

- EPC-R7300: 搭載 NVIDIA Jetson Orin Nano-Super (8GB),是一款緊湊而功能強大的邊緣電腦。

- AIR-030: 搭載 NVIDIA Jetson Orin AGX (32GB/64GB),提供更強大的AI運算能力。

這兩款平台都具備在邊緣執行複雜AI任務的潛力。實驗中,我們將在這些平台上部署sLLM模型,看看它們的表現如何。

準備就緒:軟體環境搭建 #

要在Jetson Orin平台上運行sLLM,需要一些前置準備。我們的工程師遵循了NVIDIA Jetson AI Lab的官方指引,並進行了以下關鍵步驟:

安裝 Docker #

Docker 是一個非常方便的容器化工具,可以幫助我們輕鬆部署和管理應用程式,包括AI模型運行環境。

參考 NVIDIA Jetson AI Lab 官方安裝連結: https://www.jetson-ai-lab.com/tips_ssd-docker.html

安裝 Jetson-containers #

jetson-containers 是一個包含許多常用AI框架和工具的容器集合,能簡化在Jetson平台上部署AI應用的流程。

cd /home/ubuntu/Downloads

git clone https://github.com/dusty-nv/jetson-containers

bash jetson-containers/install.sh

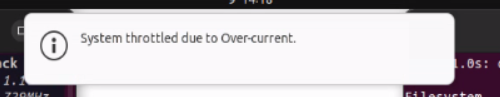

關閉系統通知 (小撇步分享!) #

在實驗過程中,工程師發現系統通知可能會干擾操作,因此進行了關閉。這雖然是個小細節,但也展現了我們在追求流暢體驗上的努力。

-

停用警告彈出視窗。

-

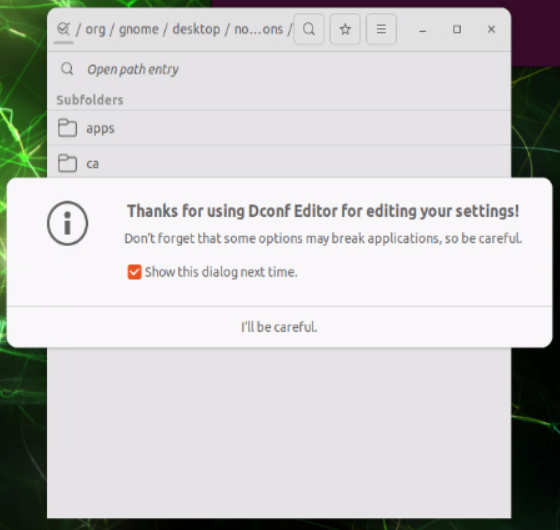

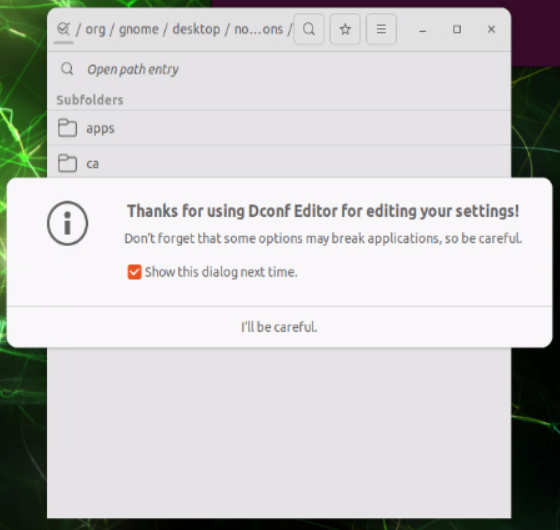

安裝 dconf-editor,使用以下指令:

sudo apt update sudo apt install dconf-editor -

安裝完成後,可以使用 dconf-editor 修改系統設定:

dconf-editor

-

依照以下路徑進入目錄層級: /org/gnome/desktop/notifications/

-

依照圖示關閉,警告彈出視窗將會被停用。

核心部署:Ollama 與 Open WebUI #

為了方便管理和互動sLLM模型,我們使用了 Ollama 和 Open WebUI 這兩個工具。Ollama 是一個輕量級的框架,可以輕鬆地在本地運行各種開源語言模型;而 Open WebUI 則提供了一個友善的網頁介面,讓我們可以直接在瀏覽器中與模型互動。

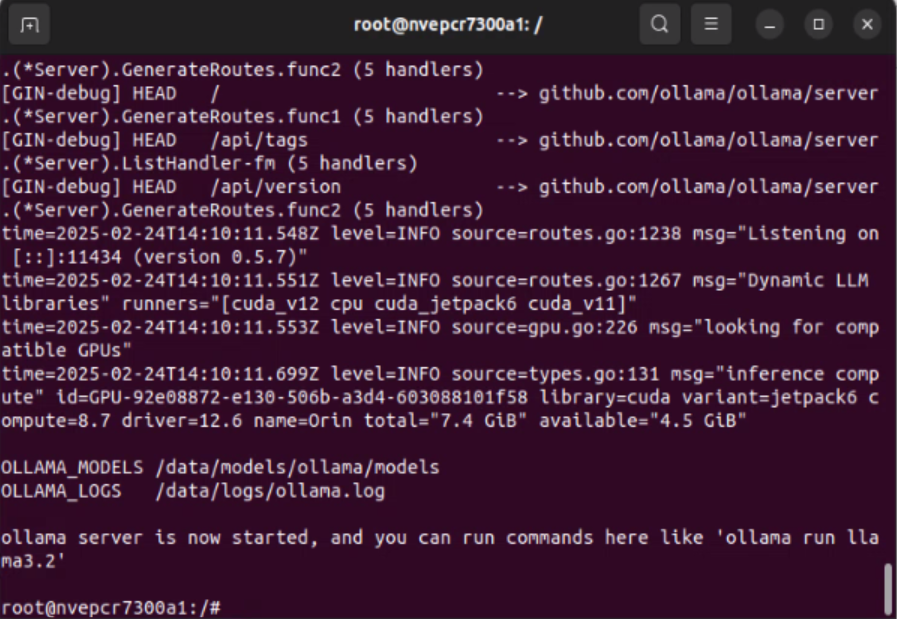

啟動 Ollama Docker 容器 #

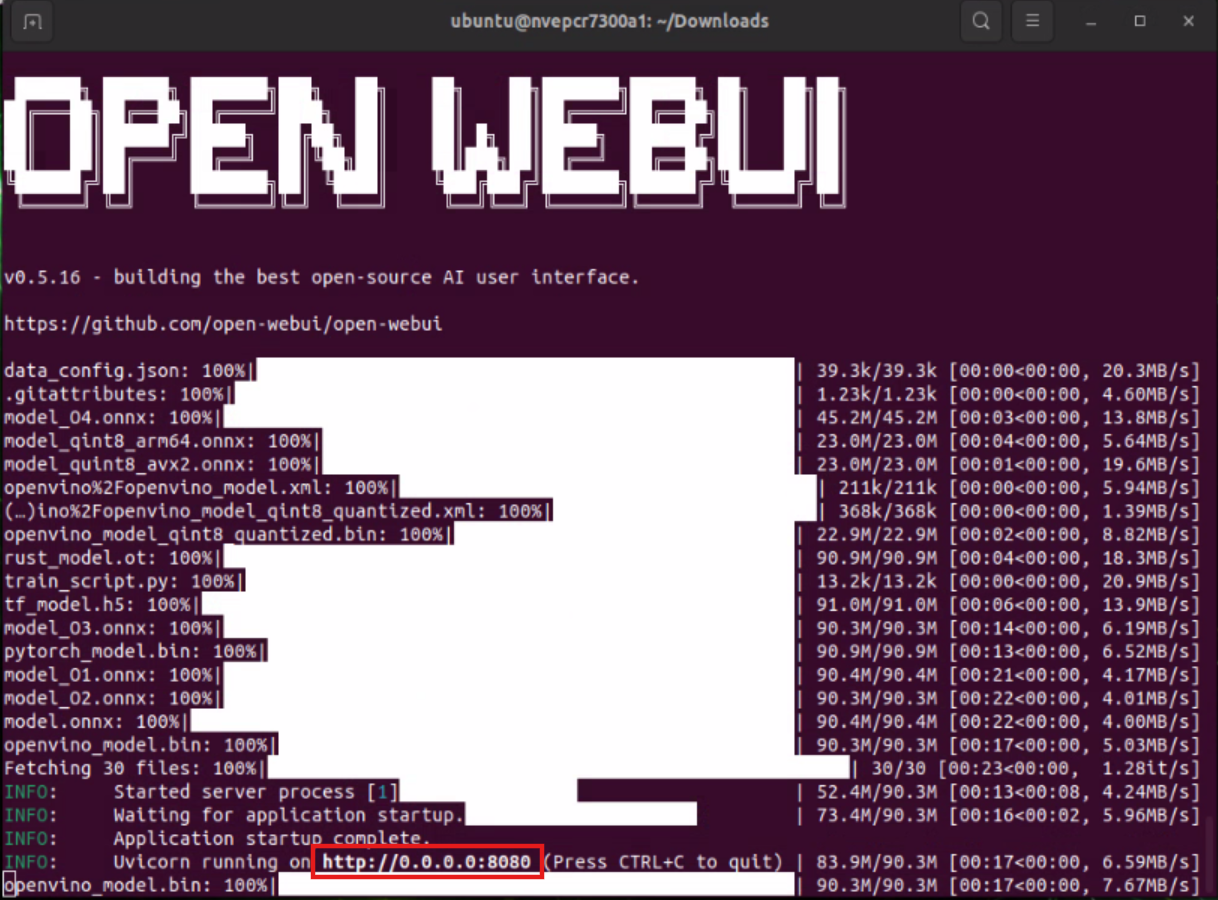

jetson-containers run --name ollama dustynv/ollama:r36.4.0

執行指令後請保持 CMD 視窗開啟。

啟動 Open WebUI #

開啟另一個 CMD 視窗。 要運行一個 Open WebUI 伺服器供客戶端瀏覽器連接,使用 open-webui 容器:

docker run -it --rm --network=host -e WEBUI_AUTH=False --add-host=host.docker.internal:host-gateway ghcr.io/open-webui/open-webui:main

執行指令後請保持 CMD 視窗開啟。

實際體驗:與sLLM互動! #

環境搭建完成後,最令人期待的部分來了:透過 Open WebUI 與 DeepSeek R1 模型進行互動!

基本使用步驟 #

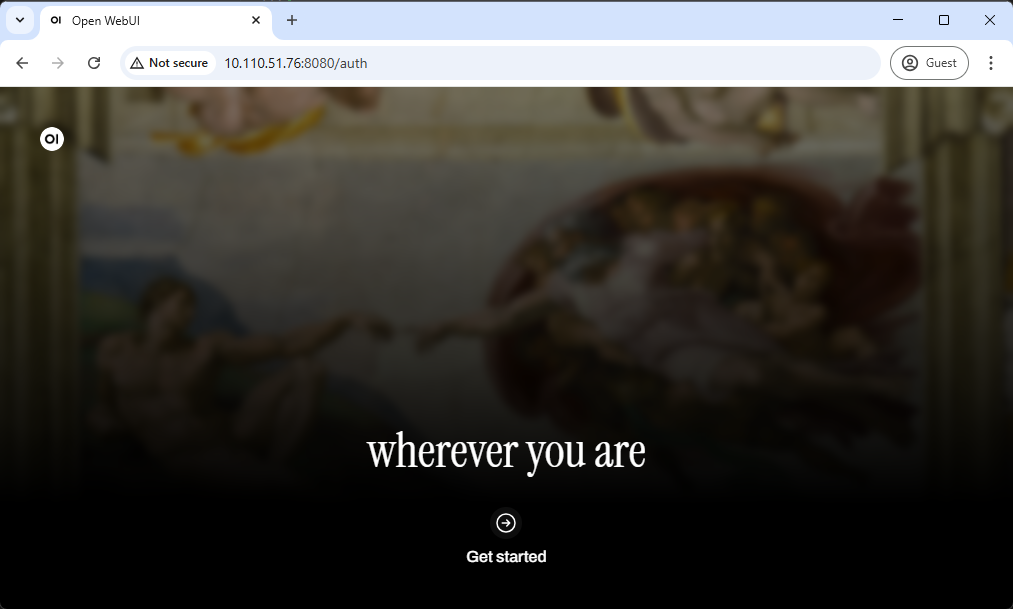

步驟 1. 透過網頁瀏覽器存取 http://0.0.0.0:8080 (IP 位址請參考上方 CMD 視窗) #

您將看到如下的初始網頁。

點擊 " Get started “。

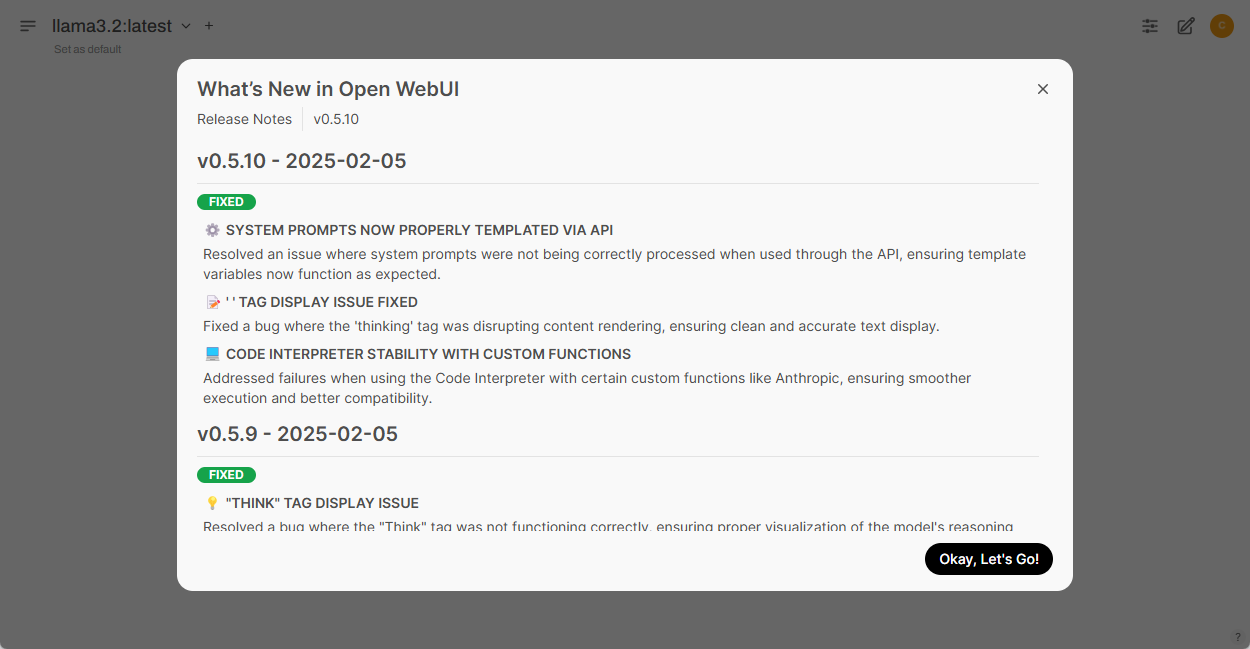

步驟 2. 點擊 " Okay, Let’s Go! " 按鈕繼續 #

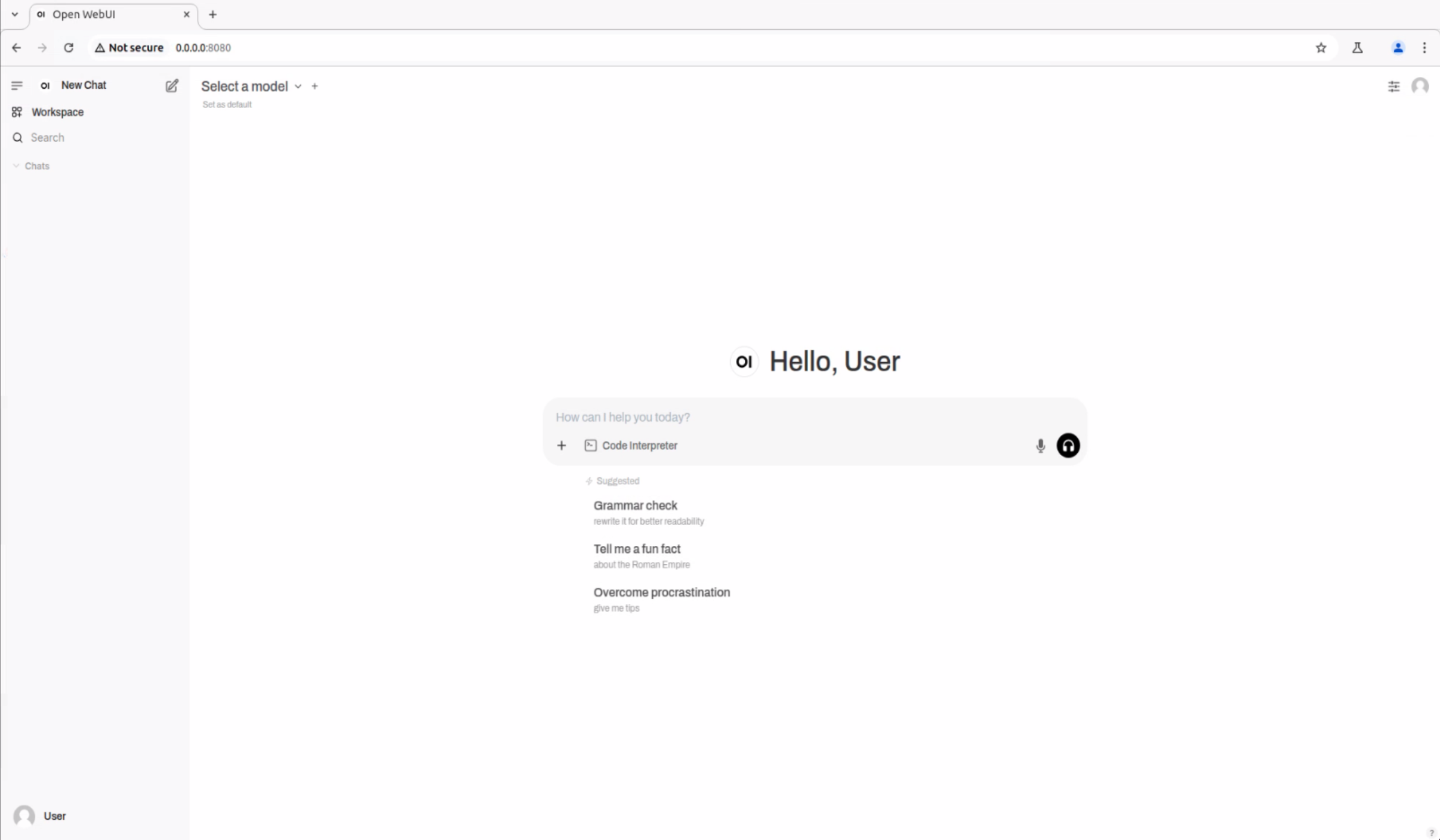

一切設定完成後,您應該會看到如下的 UI 介面。

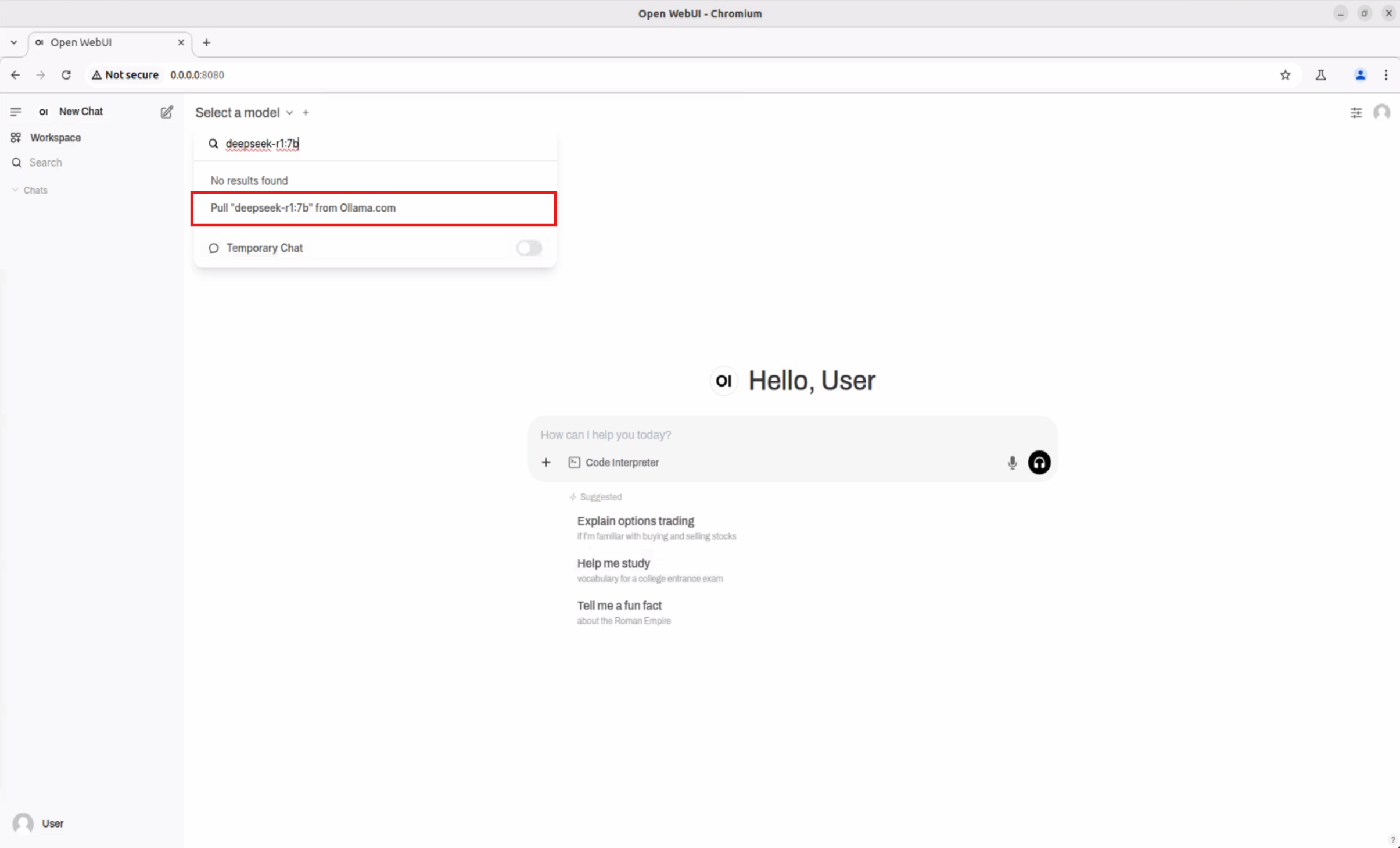

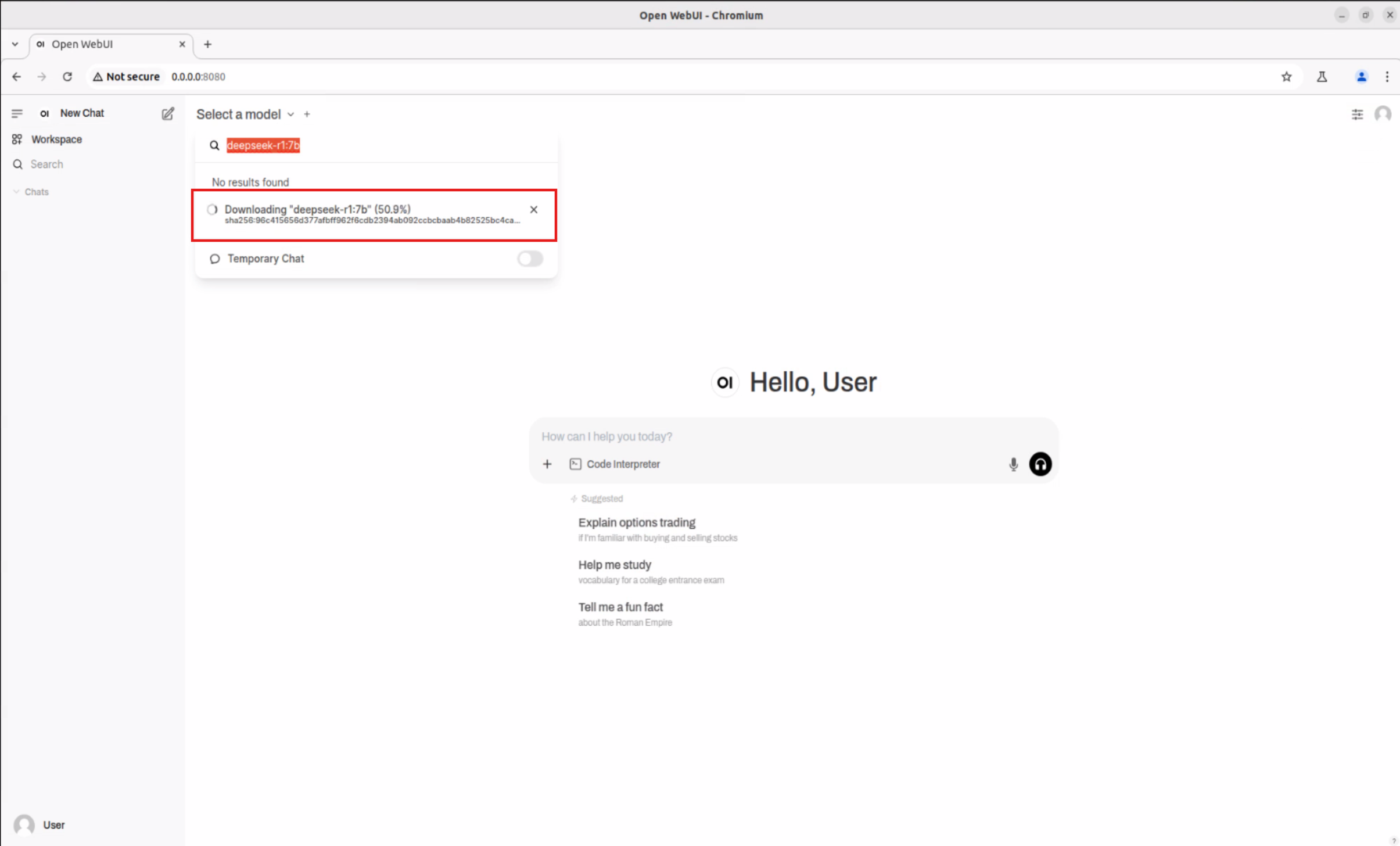

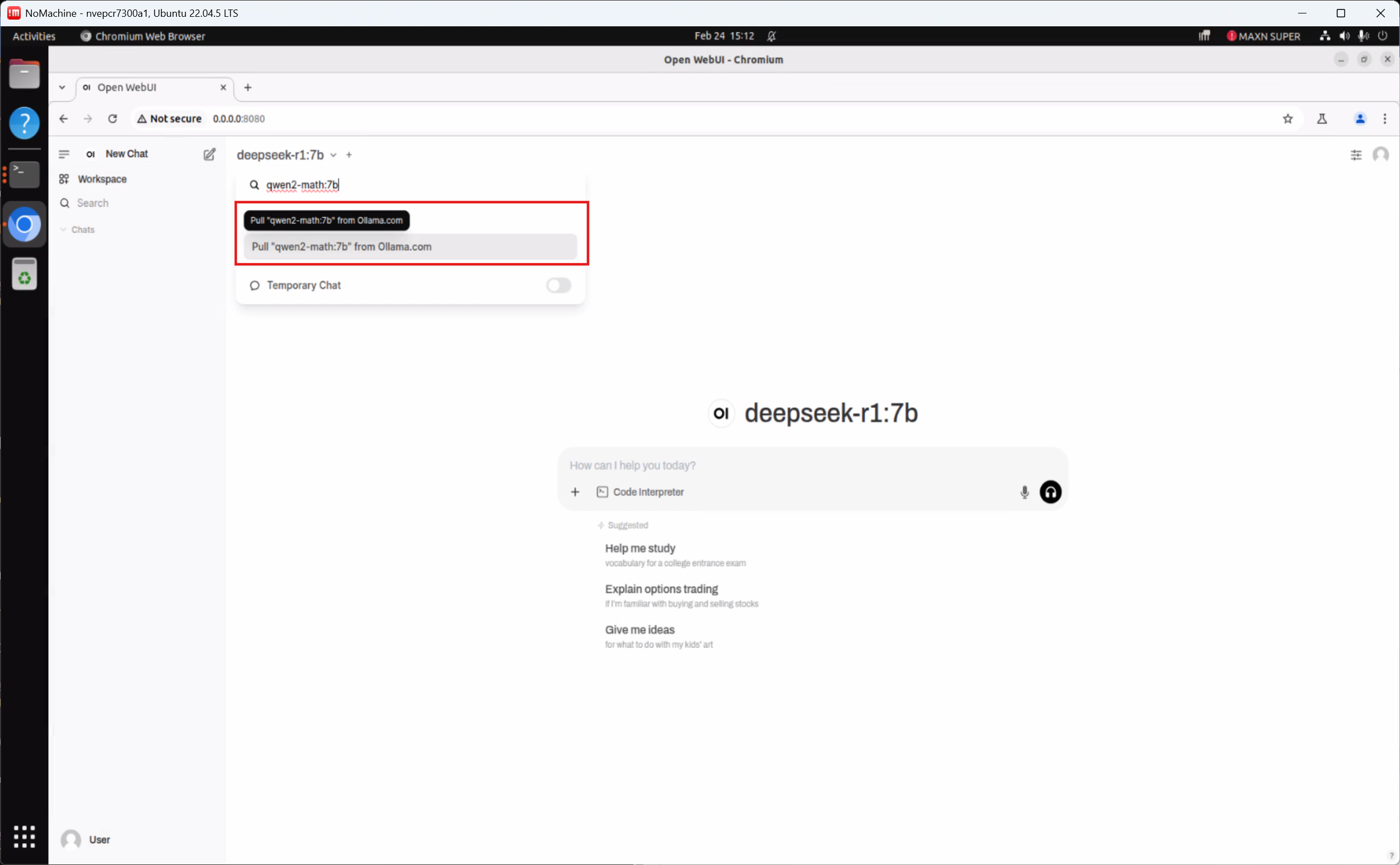

3. 下載 deepseek-r1:7b (DeepSeek R1 Qwen-7B) 模型 #

要下載 deepseek-r1:7b 模型,點擊 “Select a model” 旁邊的下拉選單。在 “🔎 Search a model” 欄位中輸入您想嘗試的模型名稱。

選定後,系統會提示您直接從 Ollama 下載模型。

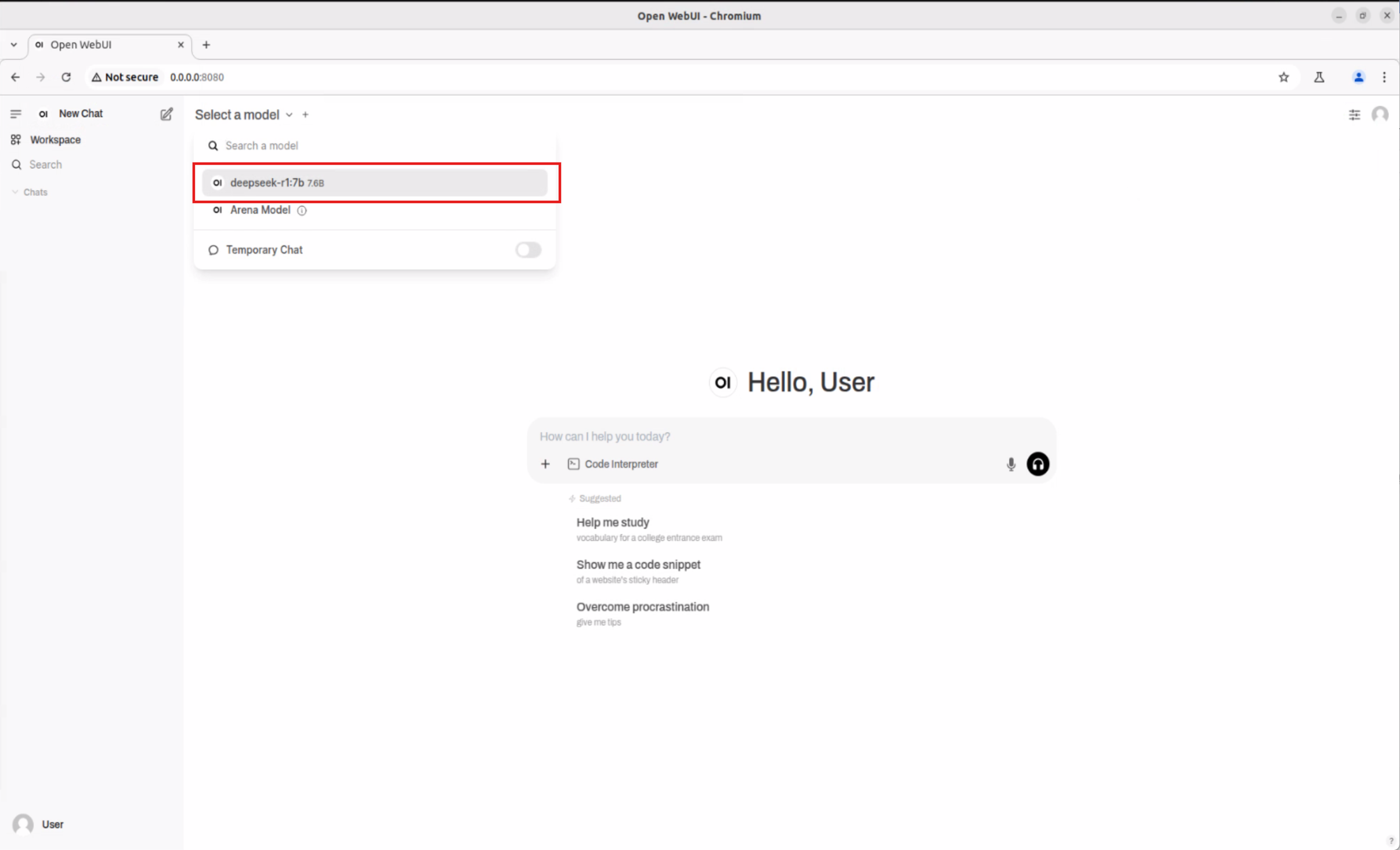

下載完成後,從列表中選擇新下載的模型。在我們的例子中,是 deepseek-r1:7b 模型。

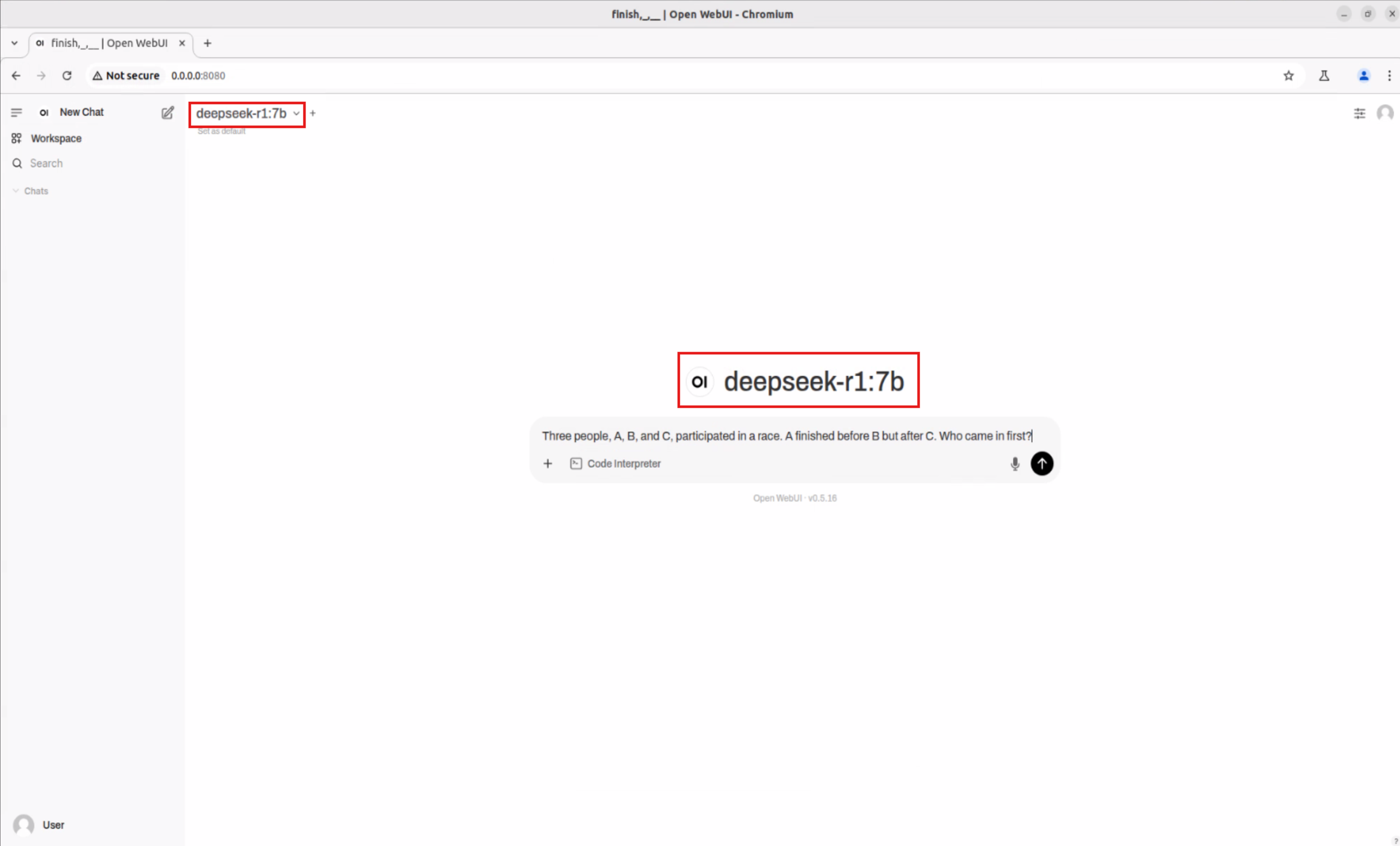

步驟 4. 開始與模型互動 #

選定所需的模型後, 您現在可以開始與模型互動,就像使用任何其他 LLM 聊天機器人一樣。

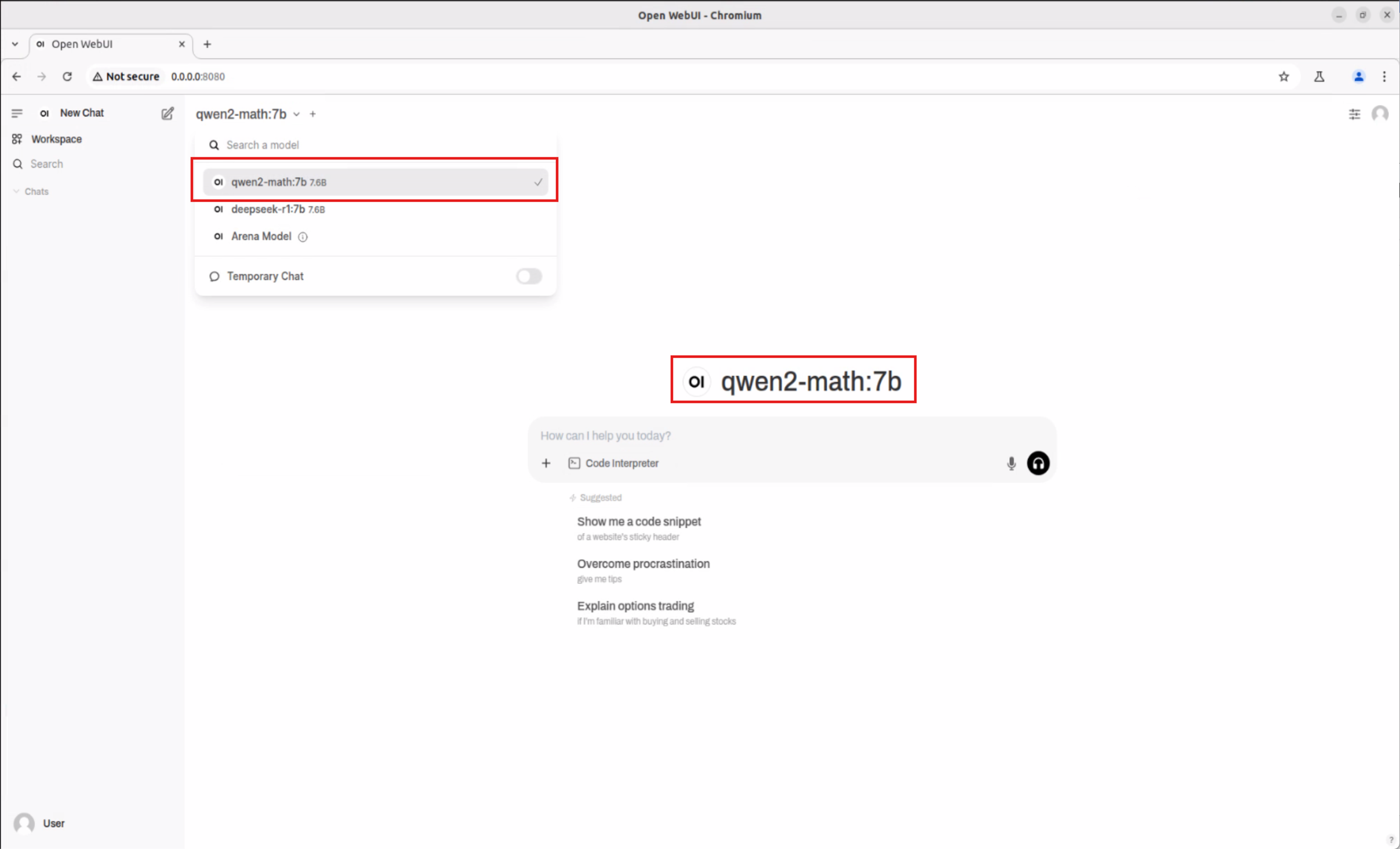

下載 Qwen2.5-Math:7b 模型 #

參考步驟 3 ~ 步驟 4

切換至 Qwen2.5-Math:7b 模型

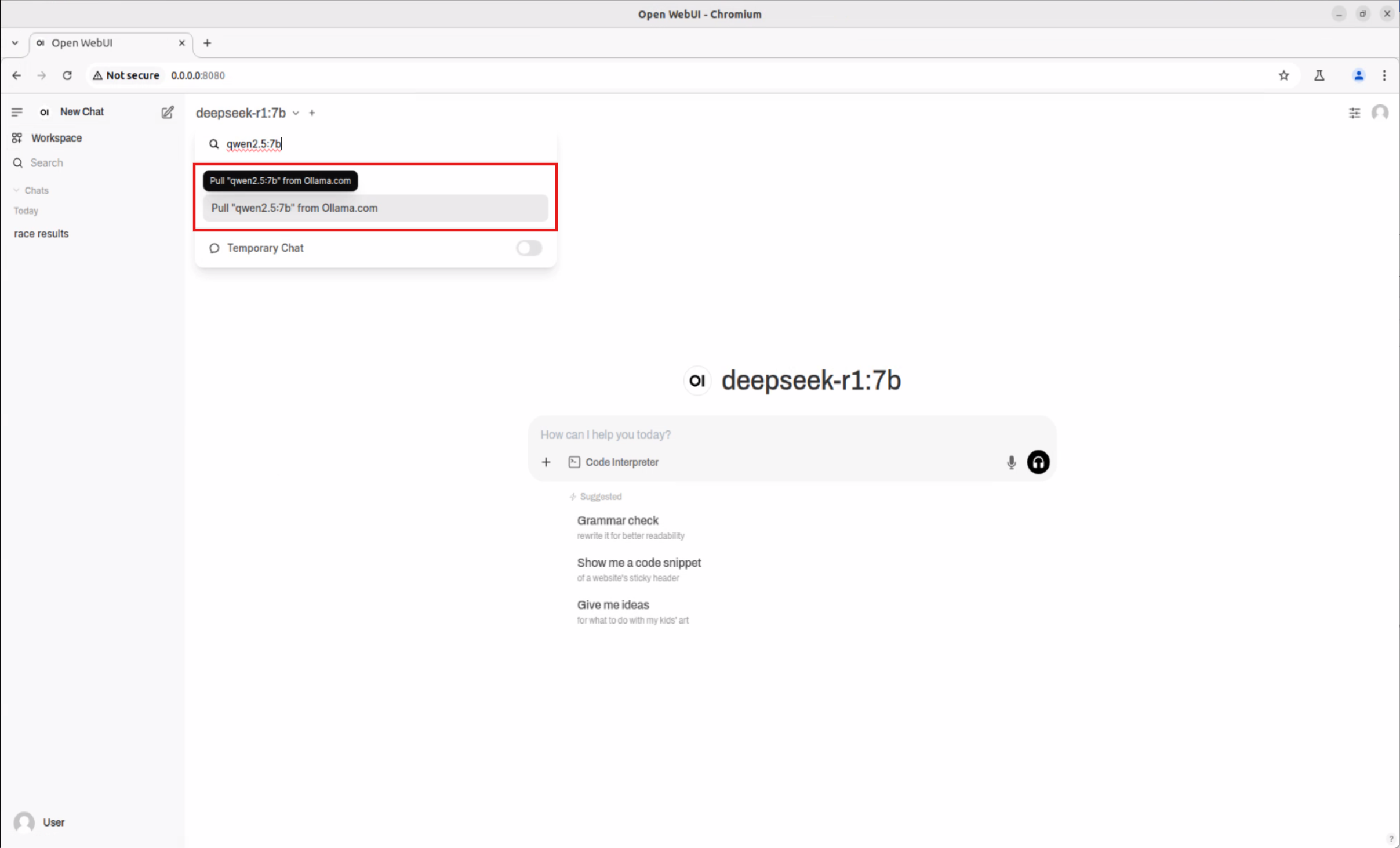

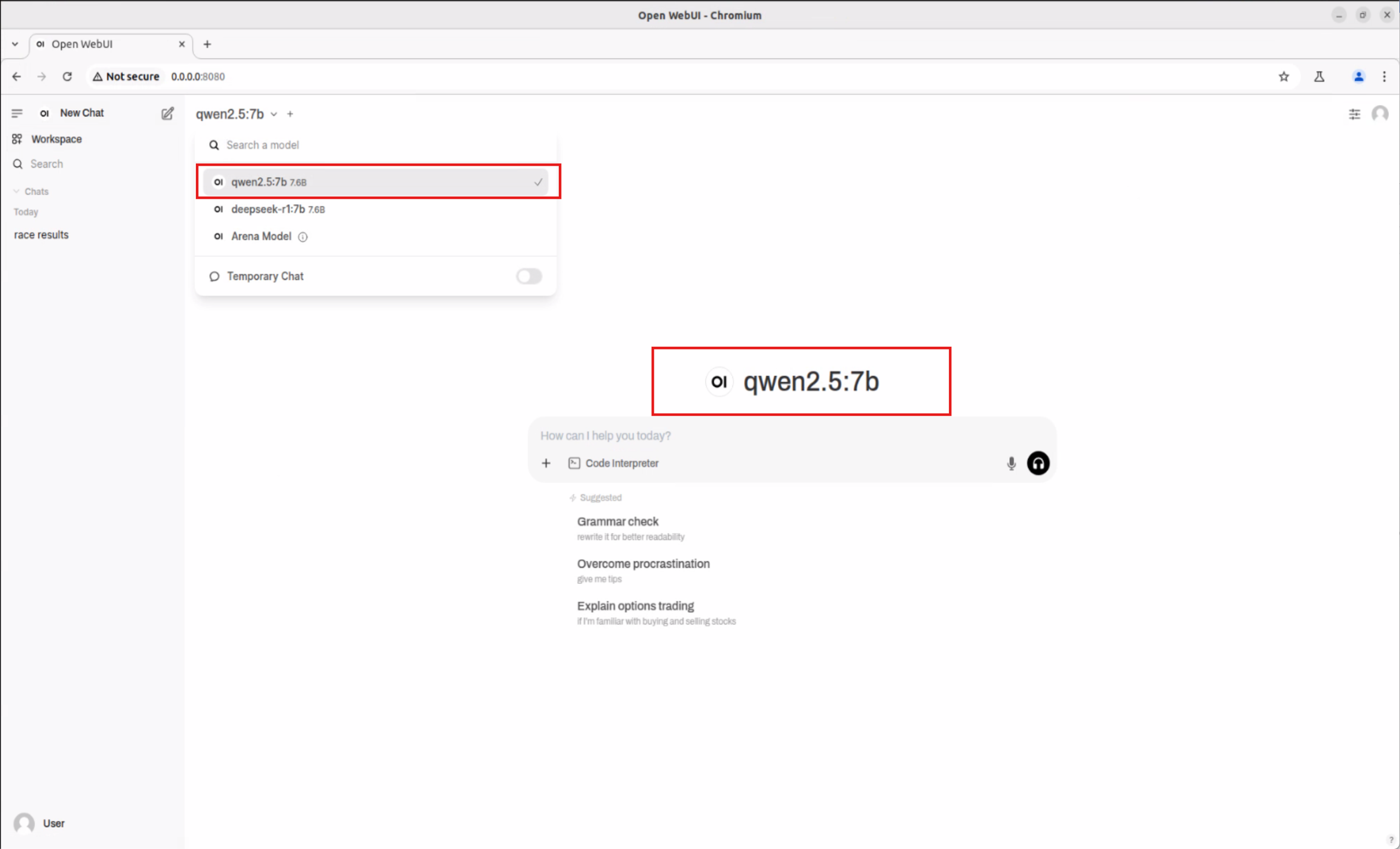

下載 Qwen2.5:7b 模型 #

參考步驟 3 ~ 步驟 4

切換至 Qwen2.5:7b 模型

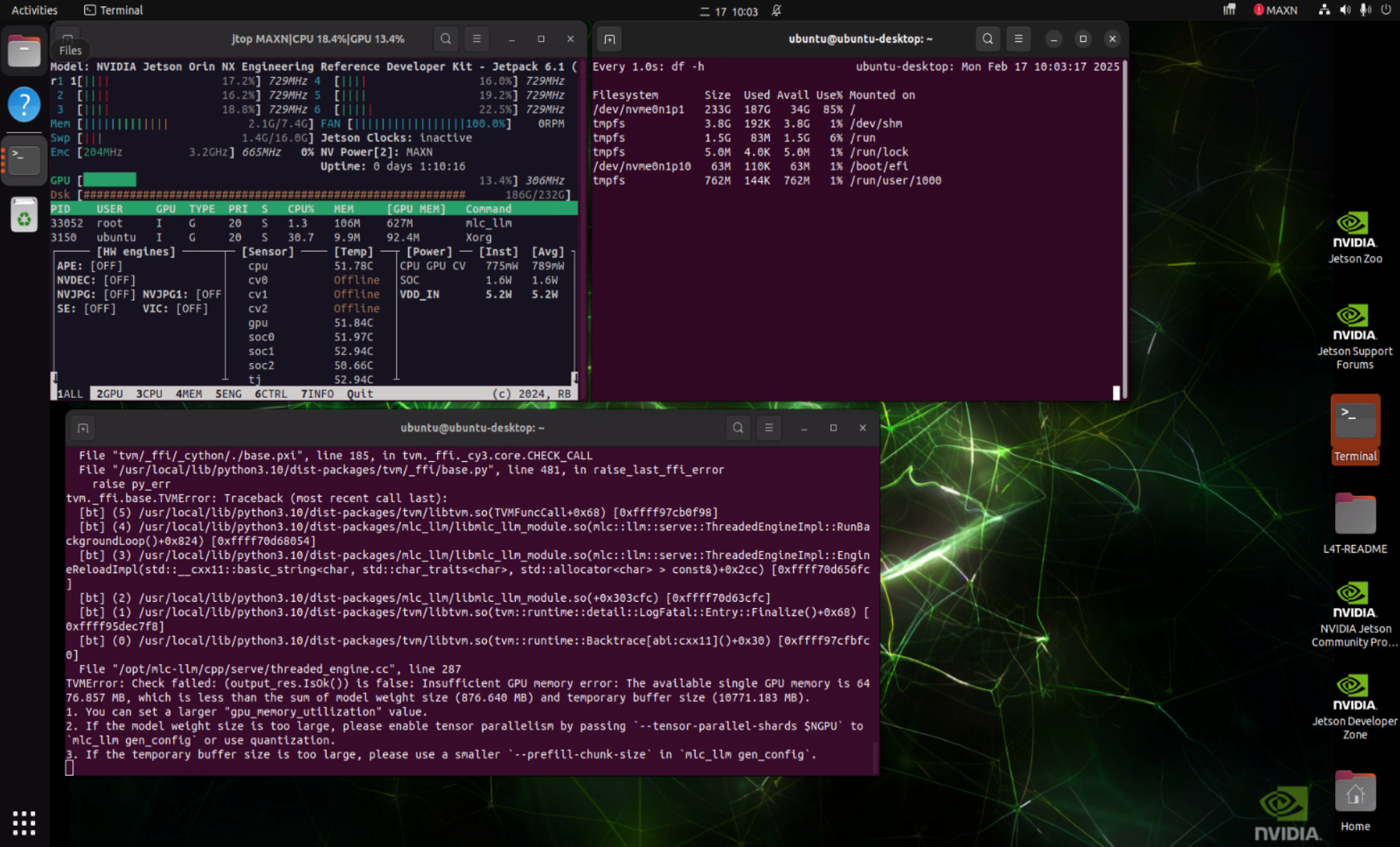

實驗小插曲:

在實驗過程中,我們也嘗試了使用 MLC 推理框架運行 Qwen 架構的模型,但遇到了錯誤。這部分我們已經諮詢了 NVIDIA 官方尋求支援。這也說明了在新技術探索的路上,總會遇到需要克服的挑戰,而研華的工程師團隊正積極地與合作夥伴一同解決這些問題,確保技術的成熟與穩定。

實驗成果與應用展望 #

這項實驗成功地證明了在研華基於 NVIDIA Jetson Orin 的邊緣平台上運行 DeepSeek R1 等 sLLM 模型是可行的!

這意味著什麼呢?

- 強大的邊緣AI能力: 我們的平台不僅能處理傳統的電腦視覺任務,現在更能執行具備語言理解和生成能力的 sLLM,大幅擴展了邊緣AI的應用範疇。

- 更多元的模型支援: 除了 DeepSeek R1,我們也成功測試了 Qwen 系列模型,展現了平台對不同 sLLM 架構的良好兼容性。

- 開啟創新應用大門: 想像一下,在智慧工廠中,機器手臂可以直接理解自然語言指令;在零售場景,自助服務機可以提供更智能的互動;在醫療領域,邊緣裝置可以進行初步的語音病歷記錄和分析。這些都因為 sLLM 在邊緣的運行成為可能。

- 研華的持續研發力: 這次實驗再次證明了研華在邊緣AI領域的積極投入和研發實力。我們不斷探索最新的AI技術,並將其整合到我們可靠、高效能的硬體平台中,為客戶提供領先的解決方案。

與以往將LLM完全依賴雲端的方式相比,在研華的邊緣平台上運行sLLM具有顯著優勢:降低延遲、保護資料隱私、減少網路依賴,並可能降低長期營運成本。

結論與未來展望 #

這次在 Jetson Orin 平台上運行 sLLM 的實驗,是研華在邊緣AI領域邁出的重要一步。它不僅驗證了技術的可行性,更為未來的創新應用開啟了無限可能。

研華將持續投入資源,深入研究如何在邊緣裝置上優化 sLLM 的性能,探索更多先進的模型,並將這些能力整合到我們的產品和解決方案中。我們相信,透過軟硬體的緊密結合與不斷創新,研華將能協助各行各業的客戶,在邊緣部署更智慧、更強大的AI應用。

如果您對在研華平台上運行 sLLM 或其他邊緣AI應用感興趣,歡迎隨時與我們的AE或銷售團隊聯繫,一起探索邊緣AI的無限潛力!